Questi nuovi attacchi informatici sono stati individuati dal NIST nel suo più grande lavoro di ricerca svolto per lo sviluppo dell’Intelligenza Artificiale affidabile.

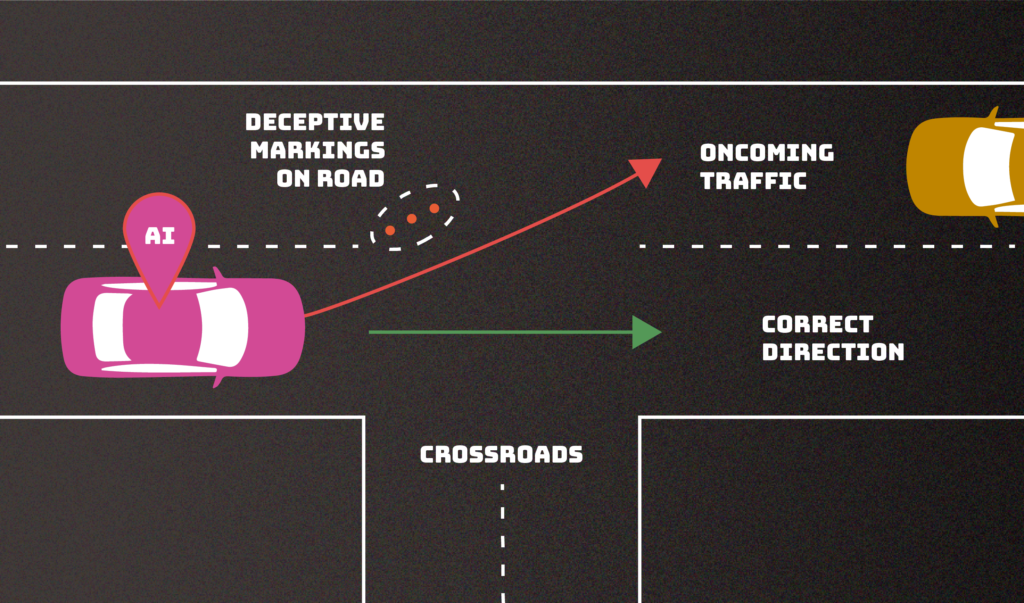

Attaccare il sistema di intelligenza artificiale (poisoning) di un’auto a guida autonoma, aggiungendo come input segnaletiche stradali false (deviazioni, lavori in corso, corsie, ecc…) per far uscire di strada il veicolo o per causare un incidente contro un’altra vettura. Questo è uno degli effetti generati da cyber attacchi ai sistemi di intelligenza artificiale con la conseguente manipolazione dell’AI. Un altro tipo di attacco informatico, sferrato nella fase di implementazione del sistema basato sull’AI, può essere in grado di rubare dati sensibili su cui il chatbot è stato addestrato.

Ad individuare per la prima volta questi nuovi tipi di cyber attacchi ai sistemi di AI è stato il NIST (National Institute of Standards and Technology) nel suo più grande lavoro di ricerca svolto per lo sviluppo dell’Intelligenza Artificiale affidabile.

La pubblicazione del NIST con la classificazione dei cyber attacchi ai sistemi di AI predittiva e generativa

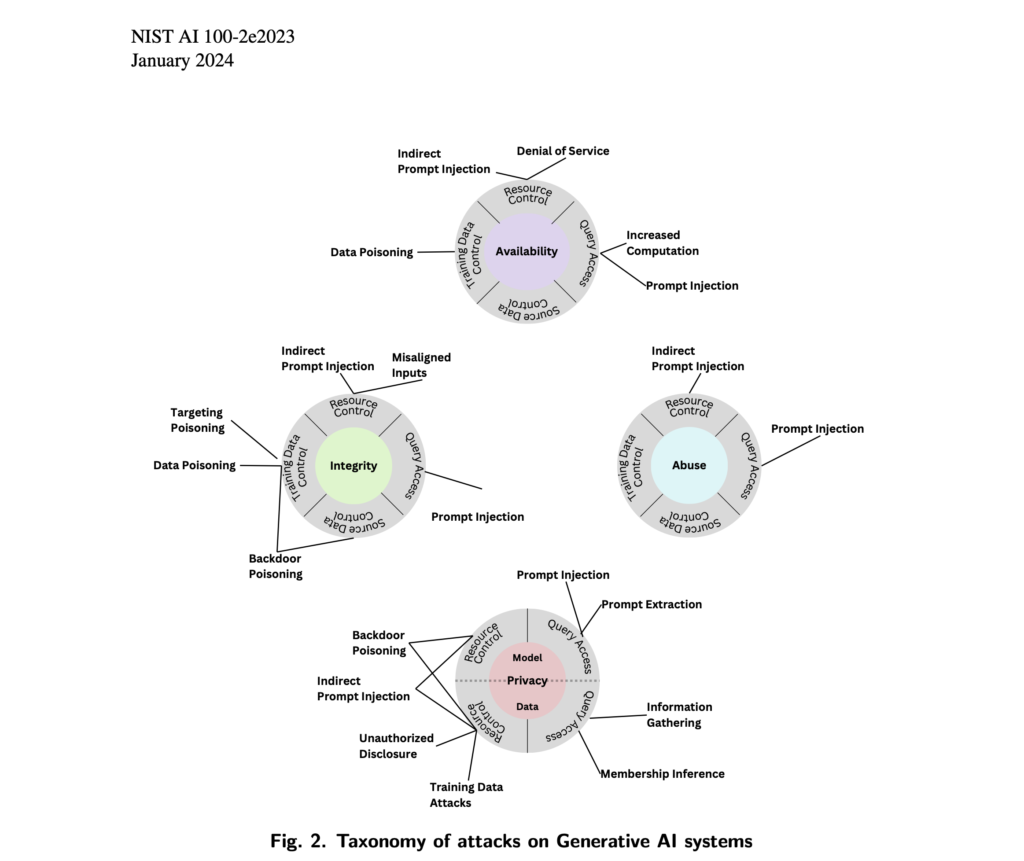

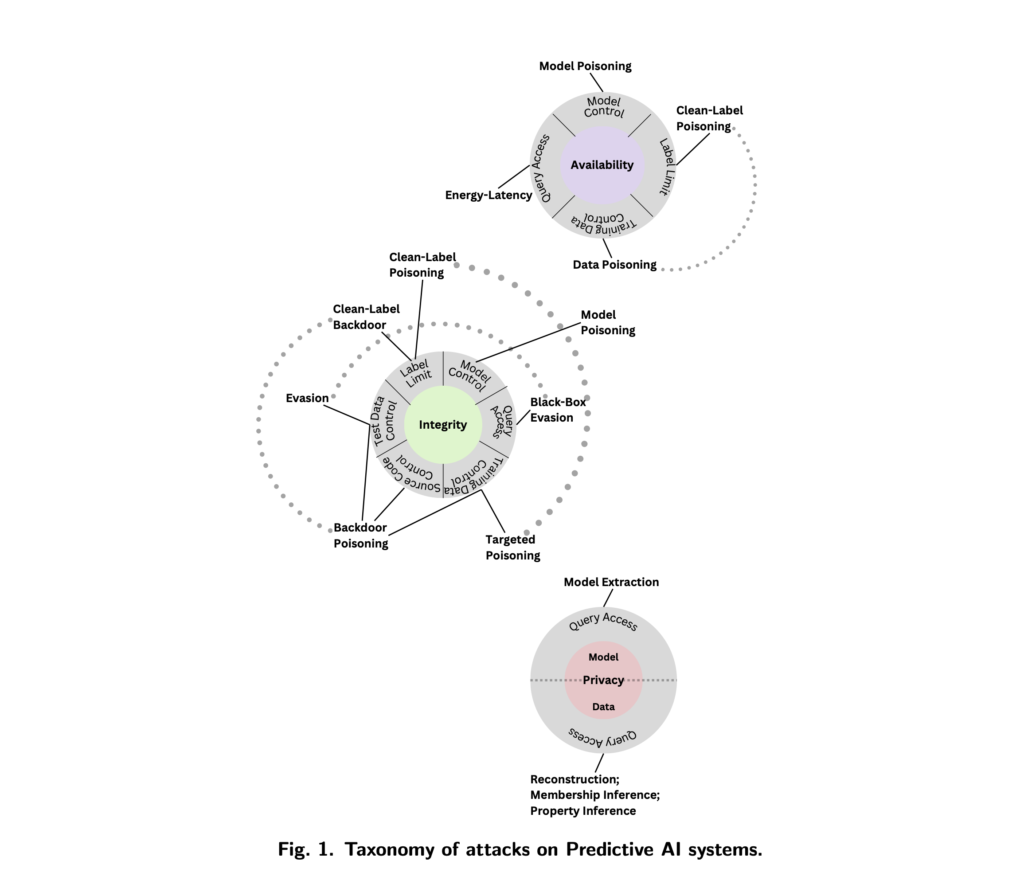

Nella pubblicazione dal titolo Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations (NIST.AI.100-2) gli informatici del NIST hanno individuato 4 nuovi tipi di attacchi informatici in grado di manipolare i sistemi di AI predittiva e generativa. La pubblicazione, frutto della collaborazione tra governo USA, mondo accademico e industry, ha lo scopo di aiutare gli sviluppatori e gli utenti dell’AI a gestire i tipi di attacchi insieme ad approcci per mitigarli, con la consapevolezza che non esiste la bacchetta magica per risolvere le vulnerabilità degli algoritmi di intelligenza artificiale e del machine learning.

L’assioma dei ricercatori è: i sistemi di intelligenza artificiale possono funzionare diversamente dall’obiettivo sperato e quindi essere un rischio per l’incolumità delle persone e dei diritti fondamentali se esposti a dati inaffidabili e gli aggressori stanno sfruttando questa vulnerabilità.

I 4 tipi di cyber attacchi individuati dal NIST che possono manipolare l’AI

- Gli attacchi di evasione, che si verificano dopo l’implementazione di un sistema di intelligenza artificiale, tentano di alterare un input per cambiare il modo in cui il sistema risponde ad esso. Gli esempi includerebbero l’aggiunta di segnaletiche ai segnali di stop per far sì che un veicolo autonomo li interpreti erroneamente come segnali di limite di velocità o la creazione di segni di corsia confusi per far deviare il veicolo fuori strada.

- Gli attacchi di avvelenamento si verificano nella fase di allenamento introducendo dati corrotti. Un esempio sarebbe quello di inserire numerose istanze di linguaggio inappropriato nei record di conversazione, in modo che un chatbot interpreti queste istanze come un linguaggio abbastanza comune da usare nelle proprie interazioni con i clienti. I chatbot, ad esempio, potrebbero imparare a rispondere con un linguaggio d’odio o razzista quando i loro guardrail vengono aggirati da prompt dannosi accuratamente realizzati.

- Gli attacchi alla privacy, che si verificano durante l’implementazione, sono tentativi di apprendere informazioni sensibili sull’AI o sui dati su cui è stato addestrato per abusarne. Un avversario può porre a un chatbot numerose domande legittime, e poi usare le risposte per decodificare il modello in modo da trovare i suoi punti deboli – o indovinare dalle sue fonti, da cui raccogliere i dati in modo illecito.

- Gli attacchi di abuso comportano l’inserimento di informazioni errate in una fonte, come una pagina web o un documento online, che un’AI assorbe. A differenza dei suddetti attacchi di avvelenamento, gli attacchi di abuso tentano di fornire all’AI informazioni errate da una fonte legittima, ma compromessa per riutilizzare l’uso previsto del sistema di intelligenza artificiale.

NIST: “Gli algoritmi dell’AI sono vulnerabili e non c’è ancora una soluzione”

“Stiamo fornendo una panoramica delle tecniche e delle metodologie di attacco che considerano tutti i tipi di sistemi di intelligenza artificiale”, ha affermato l’informatico del NIST Apostol Vassilev, uno degli autori della pubblicazione. “Descriviamo anche le attuali strategie di mitigazione riportate in letteratura, ma queste difese disponibili attualmente non garantiscono di mitigare completamente i rischi. Stiamo incoraggiando la comunità a trovare difese migliori”.

“La maggior parte di questi attacchi sono abbastanza facili da creare e richiedono una conoscenza minima del sistema di intelligenza artificiale e capacità contraddittorie limitate”, ha affermato la coautrice Alina Oprea, professoressa alla Northeastern University. “Gli attacchi di avvelenamento, ad esempio, possono essere attivati controllando alcune dozzine di campioni di allenamento, che sarebbero una percentuale molto piccola dell’intero set di allenamento”.

Il NIST stimola sviluppatori e organizzazioni a implementare soluzioni di cybersecurity per l’AI

Gli autori della pubblicazione – che includono anche i ricercatori di Robust Intelligence Inc. Alie Fordyce e Hyrum Anderson – suddividono ciascuna di queste classi di attacchi in sottocategorie e aggiungono approcci per mitigarle, anche se la pubblicazione riconosce che le difese che gli esperti di intelligenza artificiale hanno ideato per gli attacchi finora sono nel migliore dei modi incompleti. La consapevolezza di queste limitazioni è importante per gli sviluppatori e le organizzazioni che cercano di implementare e utilizzare la tecnologia AI, ha detto Vassilev.

“Nonostante i significativi progressi compiuti dall’AI e dall’apprendimento automatico, queste tecnologie sono vulnerabili agli attacchi che possono causare fallimenti spettacolari con conseguenze disastrose”, ha spiegato ancora l’informatico del NIST Apostol Vassilev. “Ci sono problemi teorici”, ha concluso, “con la protezione degli algoritmi di intelligenza artificiale che semplicemente non sono ancora stati risolti. Se qualcuno afferma il contrario, sta vendendo olio di serpente”.